U julu prošle godine Ujedinjene nacije pozvale su na regulisanje upotrebe veštačke inteligencije, a u saopštenju su naglasili da bi države članice trebalo da uspostave zajednički dogovorena pravila „pre nego što bude prekasno“.

U objavi UN poziva se i na mehanizme za sprečavanje upotrebe AI alata za promovisanje mržnje, dezinformacija i obmanjivanja publike, što podstiče ekstremizam i pogoršava sukobe, jača stereotipe i predrasude u zajednicama širom sveta.

Činjenica je da različite profesionalne organizacije već dugo upozoravaju da je vreme, u kom veštačka inteligencija onemogućava razlikovanje činjenica od fikcije, uveliko stiglo, što stvara dodatne izazove u borbi protiv lažnih vesti i zlonamernog manipulisanja stavovima publike.

Kada pomislimo na medijski sadržaj izmenjen ili potpuno kreiran upotrebom veštačke inteligencije, najčešća asocijacija su deepfake video-sadržaji kojima je i srpska publika bila izložena putem jedne nacionalne televizije. Međutim, profesionalci iz sektora medija i tehnologije skreću pažnju na još veću opasnost - deepfake audio-sadržaje.

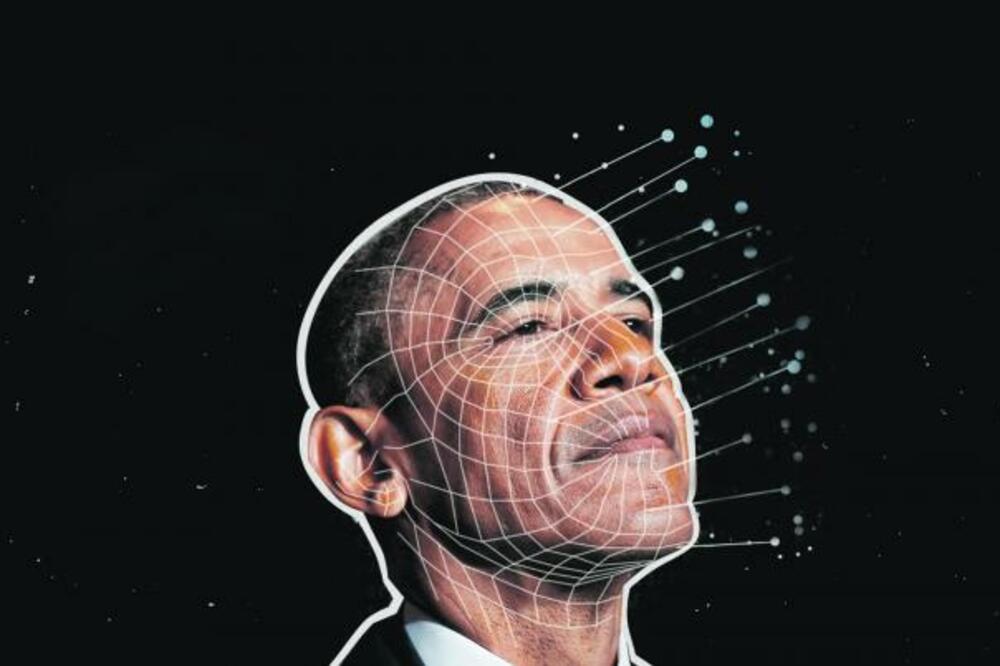

Nedavno se pojavio deepfake audio u kome se, glasom aktuelnog predsednika Sjedinjenih Država, Džoa Bajdena, šalje poruka koja je imala za cilj da obeshrabri glasače, sugerišući da njihov izlazak na izbore nije presudan. U oktobru prošle godine, predmet deepfake audio manipulacije bio je Barak Obama, a uz mnoštvo drugih primera razumljiva je sve veća zabrinutost da lažni audio-sadržaji postaju novo, snažno oružje u onlajn ratu dezinformacijama, dovodeći manipulisanje stavovima građana uoči brojnih izbornih procesa ove godine na sasvim nove nivoe.

Kreiranje deepfake audio-sadržaja je, pritom, relativno jednostavno i može ga izvesti bilo ko. Stručnjaci koji se bave digitalnom forenzikom navode da je potrebno oko par minuta autentičnog glasa osobe, a uz upotrebu jeftinog široko dostupnog alata moguće je na osnovu reference klonirati glas. Nakon toga, potrebno je samo otkucati rečenice koje želimo da čujemo i dobija se uverljiv govor za nekoliko sekundi. Osim mehanizma tekst-u-zvuk, postoji i način da se to uradi mehanizmom govor-u-govor.

Nasuprot jednostavnoj i jeftinoj proizvodnji, detekcija deepfake audio-sadržaja je mnogo kompleksnija, skupa, zahteva visoko razvijene digitalne servise i veštine. Dok deepfake video pruža mnogo više prostora za uviđanje manipulacije - od neuobičajene mimike do zamućenih delova slike - u slučaju lažnog glasa šumovima, muzikom ili prostim smanjivanjem kvaliteta snimka lakše se prikrivaju odstupanja od autentičnog.

Lažni glas Baraka Obame razotkrila je mreža NewsGuard i povezala ga sa 17 TikTok naloga koji su koristili hiperrealističnu tehnologiju AI glasa sa ciljem dezinformisanja. NewsGuard je saopštio da je mreža naloga od maja 2023. proizvela oko 5.000 video-snimaka, od kojih mnogi sadrže glasovne snimke očigledno AI generisane.

TikTok, formalno, zahteva jasne oznake za sadržaj koji je proizveden upotrebom AI, ali pomenuti video-snimci sa lažnim glasom Baraka Obame nisu bili registrovani, niti markirani. Paralelno, kompanija Meta je razvila AudioSeal - prvi audio sistem „vodenog žiga“, specijalizovanog za lokalizaciju sintetizovanog govora unutar audio-klipova, što jeste krupan korak, ali ne i konačno rešenje problema.

U borbi protiv dezinformisanja upotrebom deepfake sadržaja biće neophodna koordinisana i simultana akcija industrije, zakonodavaca i obrazovnog sistema. Već sada je izvesno da ozbiljna, sistemska regulacija daleko zaostaje za dešavanjima u praksi i svakodnevnom životu.

Autorka je teoretičarka medija

Bonus video: